CerebrasCS2晶圆级芯片的性能超越每一个GPU

Cerebras刚刚宣布了公司的关键时刻,这是全球最广泛的自然语言处理(NLP)AI模型在单一设备中的最重要的学习计划,开发和制造世界上最大的加速器芯片CS-2晶圆级引擎。

Cerebras训练的人工智能模型爬升到了一个独特而非凡的200亿参数。Cerebras无需跨多个加速器扩展工作负载即可完成此操作。Cerebras的胜利对于机器学习至关重要,因为与以前的模型相比,软件需求的基础设施和复杂性有所降低。

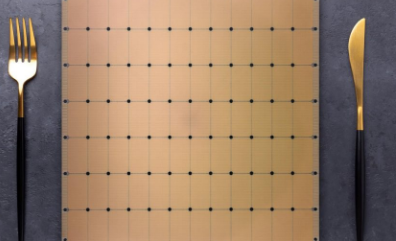

WaferScaleEngine-2刻在单个7nm晶圆上,相当于市场上数百个优质芯片,并具有2.6万亿个7nm晶体管。除了晶圆和晶体管,WaferScaleEngine-2还包含850,000个内核和40GB的集成缓存,功耗为15kW。Tom'sHardware指出,“单个CS-2系统本身就类似于超级计算机”。

CerebrasCS-2晶圆级芯片的性能超越了每一个GPU,打破了在单个设备上训练的最大AI模型的记录1

Cerebras在单个芯片中使用200亿参数的NLP模型的好处使该公司能够减少在训练数千个GPU、硬件和扩展要求方面的开销。反过来,该公司可以消除在芯片上划分各种模型的任何技术困难。该公司表示,这是“NLP工作负载中最痛苦的方面之一,[...]需要数月才能完成”。

这是一个量身定制的问题,不仅对于每个处理过的神经网络、GPU规格,以及结合所有组件的整个网络来说都是不寻常的,研究人员在第一部分训练之前必须注意这些问题。培训也是单独的,不能在多个系统上使用。

在NLP中,更大的模型被证明更准确。但传统上,只有少数几家公司拥有必要的资源和专业知识来完成分解这些大型模型并将它们分散到数百或数千个图形处理单元的艰苦工作。结果,很少有公司可以训练大型NLP模型——这对于行业的其他人来说太昂贵、太耗时且无法使用。今天,我们很自豪能够普及GPT-3XL1.3B、GPT-J6B、GPT-313B和GPT-NeoX20B,使整个AI生态系统能够在几分钟内建立大型模型并在单个CS-2.

目前,我们已经看到系统在使用较少参数的情况下表现异常出色。Chinchilla就是一个这样的系统,它不断超过GPT-3和Gopher的700亿个参数。然而,Cerebras的成就非常重要,因为研究人员将发现他们将能够在其他人无法计算和创建的新WaferScaleEngine-2上逐渐精细的模型。

CerebrasCS-2晶圆级芯片的性能超越了每个GPU,打破了在单个设备上训练的最大AI模型的记录2

大量可用参数背后的技术使用公司的权重流技术,允许研究人员“解耦计算和内存占用,允许内存扩展为存储人工智能工作负载中快速增加的参数数量所需的任何数量。”反过来,只需几个标准命令,设置学习所需的时间将从几个月减少到几分钟,从而可以在GPT-J和GPT-Neo之间完美切换。

Cerebras能够以经济高效、易于访问的方式将大型语言模型带给大众,开启了令人兴奋的AI新时代。它为无法花费数千万美元的组织提供了一个简单且廉价的进入大联盟NLP的入口。看到CS-2客户在海量数据集上训练GPT-3和GPT-J类模型时的新应用和发现将会很有趣。

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时候联系我们修改或删除,多谢。