首页 >> 社会 >

用于多个跨域少量学习的团队知识蒸馏

尽管小样本学习(FSL)取得了很大进展,但它仍然是一个巨大的挑战,尤其是当源集和目标集来自不同领域时,也称为跨域小样本学习(CD-FSL)。利用更多的源域数据是提高CD-FSL性能的有效途径。然而,来自不同源域的知识可能会相互纠缠和混淆,这会损害目标域的性能。

2023年3月27日,天津大学季仲教授带领的研究团队在FrontiersofComputerScience上发表了他们的新研究。

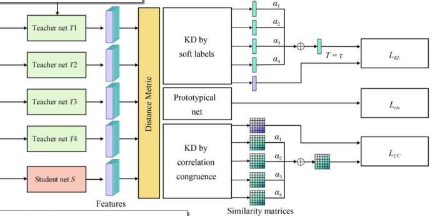

该团队提出团队知识蒸馏网络(TKD-Net)来解决CD-FSL,探索一种帮助多位教师合作的策略。他们将知识从教师网络的合作中提取到元学习框架中的单个学生网络中。它结合了面向任务的知识蒸馏和教师之间的多重合作,以培养对看不见的任务具有更好泛化能力的高效学生。此外,他们的TKD-Net同时采用基于响应的知识和基于关系的知识来传递更全面和有效的知识。

具体来说,他们提出的方法包括两个阶段:教师发展阶段和多层次知识蒸馏阶段。他们首先通过监督学习分别使用来自多个可见域的训练数据对教师模型进行预训练,其中所有教师模型都具有相同的网络架构。在获得多个特定领域的教师模型后,多层次的知识在元学习范式中从教师的合作转移到学生。

面向任务的蒸馏有利于学生模型快速适应少样本任务。学生模型是基于原型网络和教师模型提供的软标签进行训练的。此外,他们还进一步探索了嵌入在相似性中的知识,并探索了教师的相似性矩阵,以转移小样本任务中样本之间的关系。它引导学生学习更具体、更全面的信息。

未来的工作可能侧重于自适应地调整多个教师模型的权重,并寻找更多的方法来有效地聚合来自多个教师的知识。

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

分享:

相关阅读

最新文章

-

【别克gl8商务车怎么样】别克GL8自推出以来,凭借其出色的舒适性、空间表现和品牌口碑,成为国内高端商务用车...浏览全文>>

-

【别克gl8商务车油耗是多少】别克GL8作为一款经典的商务车型,凭借其宽敞的内部空间、舒适的乘坐体验和较高的...浏览全文>>

-

【别克gl8商务车油耗多少】别克GL8是一款非常受欢迎的中大型MPV,广泛用于商务接待、家庭出行以及出租车等场景...浏览全文>>

-

【别克gl8商务车价格多少】别克GL8作为一款经典的商务车型,凭借其舒适性、空间表现以及品牌口碑,深受企业用...浏览全文>>

-

【别克gl8商务车价格】作为一款在国内市场广受好评的中高端商务车型,别克GL8凭借其宽敞的内部空间、舒适的乘...浏览全文>>

-

【别克gl8商务车多少钱】别克GL8作为一款经典的商务车型,凭借其舒适性、空间表现和品牌口碑,在国内市场上一...浏览全文>>

-

【别克gl8商务车的参数是怎样的】作为一款在商务用车市场中备受青睐的车型,别克GL8凭借其宽敞的空间、舒适的...浏览全文>>

-

【别克gl8商务车参数】作为一款在市场上备受关注的中高端商务车型,别克GL8凭借其宽敞的空间、舒适的驾乘体验...浏览全文>>

-

【别克gl8商务车报价参数配置】别克GL8作为一款经典的商务车型,凭借其宽敞的内部空间、舒适的乘坐体验以及较...浏览全文>>

-

【别克excelle是哪款车】“别克Excelle”这一名称在汽车市场中并不常见,可能是对别克某款车型的误写或翻译差...浏览全文>>

大家爱看

频道推荐